ChronoDepth——跨帧强一致性的视频深度计算

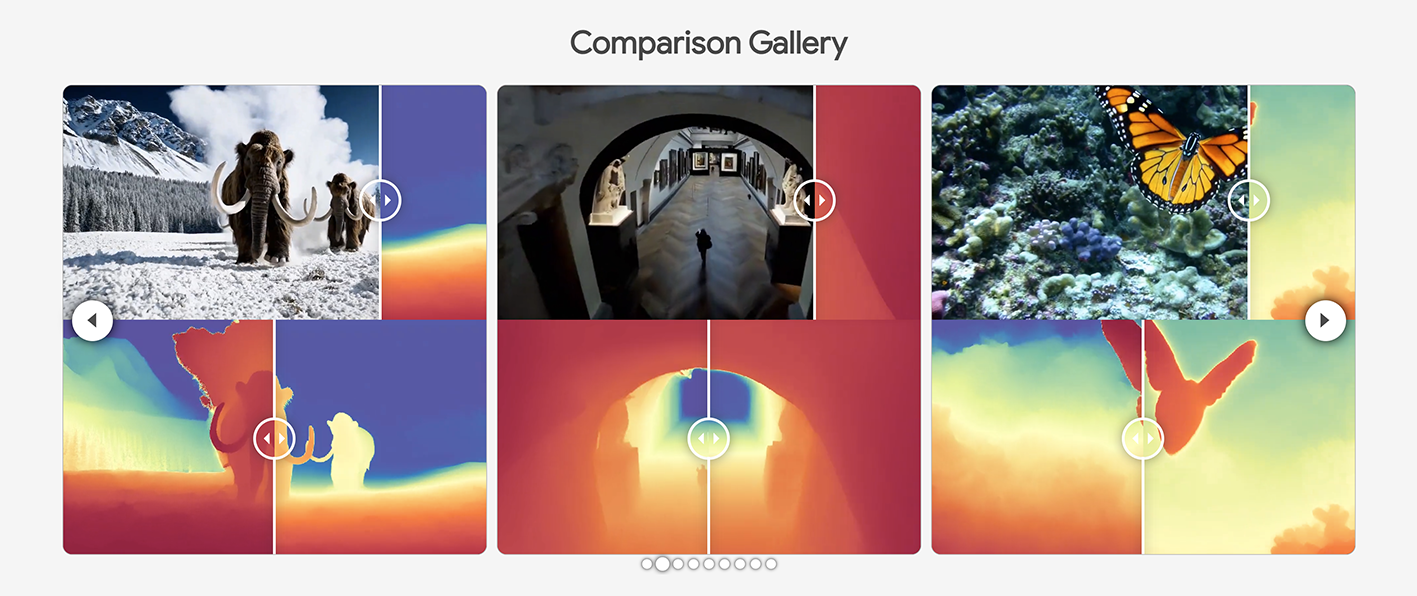

ChronoDepth 是浙大团队开发的一个框架,用于从视频中学习时间一致的深度估计。它通过整合图像和视频深度数据集,利用视频扩散模型的先验知识,实现了高空间精度和时间一致性。在深度一致性、视频生成和新视角合成等领域表现优异。

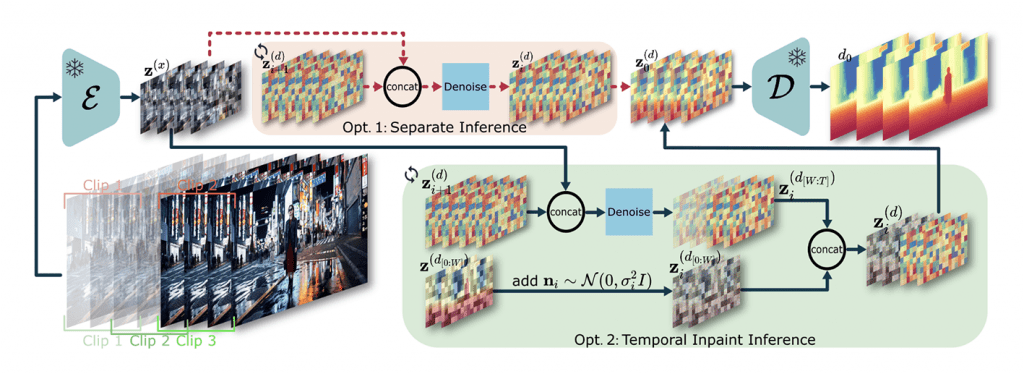

训练管道:将RGB视频条件分支添加到预训练的视频扩散模型“稳定视频扩散”中并对它进行微调,以获得一致的深度估计。使用预训练的编码器将RGB和深度视频投影到低维潜在空间中。视频深度估计器通过去噪得分匹配(DSM)进行训练。

训练包括两个阶段:首先,使用单个帧深度训练空间层;然后,我们冻结空间层,并使用随机采样长度的剪辑训练时间层。这种连续的时空微调方法比训练整个网络的性能更好。

推理管道:探索了两种推理策略。

选项1:分离推理涉及将视频分成不重叠的片段,并单独预测它们的深度。

选项2:时间插补推理表示基于先前帧的预测 𝑧(𝑧[𝑊:𝑇]) 在片段中插补后帧 𝑧(𝑧[0:𝑊])。

团队提出的时间插补增强了时间一致性。