EMO——由阿里巴巴集团智能计算研究院开发的AI图生视频模型

EMO 是一个由阿里巴巴集团智能计算研究院开发的AI图生视频模型。

它被称为”EMOTEPORTRAIT ALIVE”,能够通过一张照片和一段音频,或者视频,生成人物说任何话或唱任何歌曲的动态视频

以下是对阿里巴巴 EMO 模型的详细介绍:

- 技术原理:该技术主要包括帧编码的初始阶段、扩散过程阶段以及使用主干网络促进去噪操作。在主干网络中,应用参考注意力和音频注意力机制,对于保留角色的身份和调节角色的动作至关重要。此外,EMO 的时间模块用于操纵时间维度,并调整运动速度。

- 功能特点

- 音频驱动视频生成:根据输入的音频(如说话或唱歌的声音)和一张参考图像,快速生成具有丰富表情变化和头部动作的虚拟角色视频,无需依赖预先录制的视频片段或 3D 面部模型。

- 多语言支持:不受语言限制,支持多种语言的音频输入,能为不同语言的歌曲或对话生成相应的表情和动作。

- 风格多样性:不仅能处理普通肖像照片,还能为各种风格的肖像(如历史画作、卡通形象、3D 模型等)赋予动态和逼真的动作。

- 角色身份保持:在视频生成过程中,能够保持角色的一致性和身份特征,使生成的视频内容更加连贯和真实。

- 时间维度控制:可以根据输入音频的长度生成任意时长的视频,用户可按需调整音频长度来控制生成视频的时间长度。

- 应用场景

- 娱乐领域:用户可以将自己或喜欢的角色的照片,通过 EMO 生成唱歌、演戏等有趣的视频,用于个人娱乐或在社交平台分享。例如根据热门歌曲模板,生成自己 “演唱” 的音乐视频。

- 教育领域:可以将历史人物、卡通角色等制作成讲解知识的动态视频,让学习内容更生动有趣。如让历史人物讲解历史事件,帮助学生更好地理解和记忆。

- 广告营销:品牌可以用 EMO 将产品代言人或虚拟形象生成富有表现力的宣传视频,以不同风格和语言呈现,吸引不同受众。比如让虚拟代言人用多种语言介绍产品特点。

- 使用方式:目前 EMO 已上线通义 App,用户在通义 App 中选择歌曲、网络热梗、表情包等模板,然后上传一张肖像照片,即可让 EMO 合成演戏或唱歌的视频。不过,目前该应用暂未开放用户自定义音频的功能。

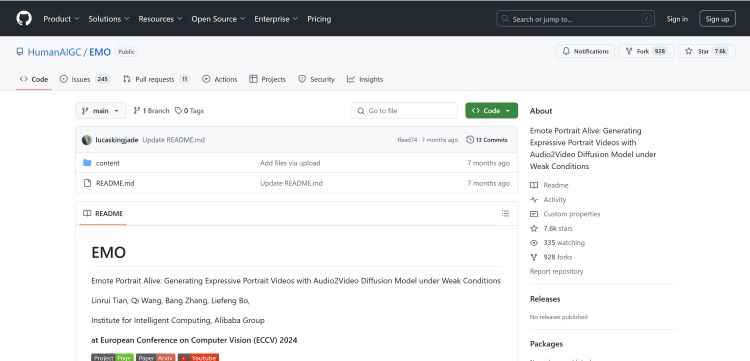

阿里巴巴 EMO GitHub 地址:https://github.com/HumanAIGC/EMO