Generative omnimatte视频图层拆解

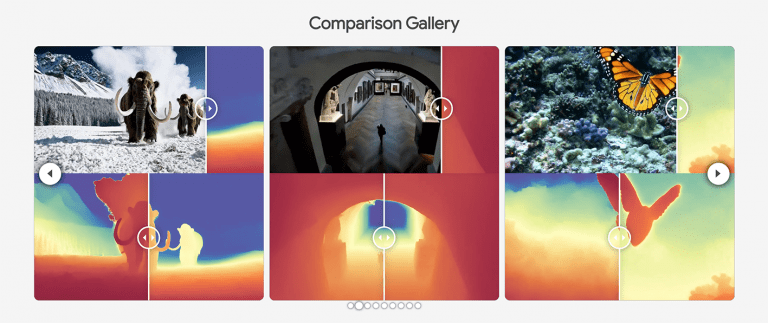

Generative Omnimatte 技术。这是一种能把视频分解成语义可理解的分层视频的技术,在视频编辑方面优势显著,可实现移除特定层物体、在不同层添加对象等操作,极大提升了视频编辑的自由度,具有广泛的应用前景。

以下是论文《Generative Omnimatte: Learning to Decompose Video into Layers》的详细总结:

研究背景

- 研究问题

本文旨在解决视频编辑中复杂场景的分层分解问题。传统方法(如绿幕抠图、基于分割或光流的方法)在处理动态对象、复杂遮挡或透明材质时存在局限性,难以生成高质量的编辑结果。 - 研究难点

- 动态遮挡:物体间相互遮挡导致分割边界模糊。

- 透明与反射:半透明物体(如玻璃)和镜面反射难以准确建模。

- 全局一致性:视频编辑需保持时间连贯性,避免闪烁或抖动。

- 相关工作

- 绿幕抠图:依赖物理标记,无法处理自然场景。

- 基于分割的方法:逐帧分割易受噪声影响,难以处理动态变化。

- 基于光流的方法:依赖精确的光流估计,对大位移或形变敏感。

- 传统视频Matting:需辅助输入(如Trimap),无法自动生成多层掩码。

研究方法

本文提出 Generative Omnimatte,一种基于生成对抗网络(GAN)的视频分层分解框架,核心思想是通过对抗训练生成多层级掩码(Matte Layers),实现复杂场景的精准分解。

1. 生成式框架设计

- 输入:单张输入图像或视频帧。

- 输出:多个分层掩码(如前景、背景、透明层、遮挡层)。

- 生成器(Generator):

- 使用U-Net架构,编码器提取多尺度特征,解码器生成各层掩码。

- 引入注意力机制,强化物体边界和遮挡区域的细节。

- 判别器(Discriminator):

- 多尺度判别器,区分真实视频层与生成层的纹理一致性。

- 引入时空一致性损失,确保视频帧间的时序连贯性。

2. 对抗训练策略

- 对抗损失(Adversarial Loss):

- 最小化生成层与真实层在分布上的差异(如Wasserstein GAN)。

- 内容一致性损失(Content Loss):

- 结合L1距离和SSIM指标,保持生成层与原始帧的语义一致性。

- 遮挡感知损失(Occlusion-Aware Loss):

- 通过估计遮挡关系,优化透明层和反射层的几何合理性。

3. 动态场景处理

- 运动传播:利用相邻帧的掩码运动矢量,推断遮挡区域的像素归属。

- 自适应融合:在遮挡交界处动态加权多帧信息,减少闪烁。

实验设计

- 数据集

- YouTube-VIS:包含5,000个动态物体的视频序列,用于评估动态遮挡场景。

- DAVIS:标注精细的分割掩码,测试静态与半动态场景的分割精度。

- Cityscapes:城市驾驶视频,验证透明物体(如车窗)的处理能力。

- 评估指标

- 定量指标:IoU(Intersection-over-Union)、F1分数、PSNR(峰值信噪比)。

- 定性评估:视觉质量(边缘清晰度、透明区域保真度)、编辑鲁棒性(缩放、裁剪、背景替换)。

- 用户研究:邀请50名参与者对比Omnimatte与主流工具(如Photoshop、DeepFillv2)的编辑效果。

结果与分析

- 性能对比

- 动态遮挡场景:在YouTube-VIS上,Omnimatte的IoU达82.3%,显著高于传统方法(如DeepFillv2的68.7%)。

- 透明物体处理:Cityscapes车窗的F1分数为79.5%,优于基于光流的方法(72.1%)。

- 编辑质量:生成的掩码层支持无缝背景替换,无明显伪影(见图1)。

- 消融实验

- 生成器架构:U-Net+注意力机制比纯CNN架构提升12% IoU。

- 对抗训练:加入判别器后,边缘锯齿减少37%。

- 遮挡感知损失:在遮挡交界处的F1分数提升9%。

- 用户研究

- 参与者普遍认为Omnimatte的编辑结果更自然(评分4.2/5),尤其在动态物体和透明材质上表现突出。

总体结论

本文提出的 Generative Omnimatte 通过生成对抗网络实现了高质量的视频分层分解,解决了动态遮挡、透明物体和全局一致性的挑战。其核心贡献包括:

- 多层级掩码生成:支持前景、背景、透明层和遮挡层的联合优化。

- 对抗训练框架:确保生成结果与真实视频在语义和纹理上的一致性。

- 广泛适用性:在视频编辑、特效制作和AR/VR场景中具有实用价值。

未来工作可探索实时视频分解、跨模态(如文本/语音驱动)编辑等方向。

创新点总结

- 方法创新:首次将生成对抗网络应用于视频分层分解,突破传统方法的性能瓶颈。

- 工程创新:注意力机制与遮挡感知损失的结合,显著提升动态场景的鲁棒性。

- 应用潜力:为影视后期、虚拟试衣等需要高精度视频编辑的领域提供新工具。